第33届ACM国际多媒体大会(Proceedings of the 32nd ACM International Conference on Multimedia,ACM MM 2025)将于2025年10月27日至10月31日在爱尔兰都柏林举行,是中国计算机学会CCF推荐的A类国际会议。厦门大学媒体分析与计算实验室八篇论文被录用, 录用论文简要介绍如下:

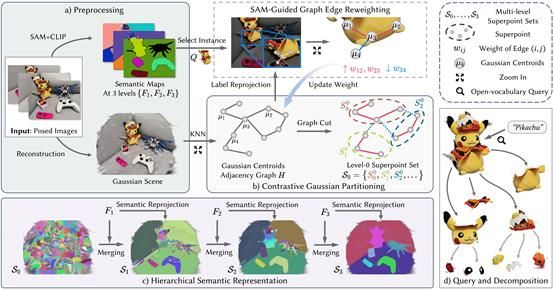

01. Training-Free Hierarchical Scene Understanding for Gaussian Splatting with Superpoint Graphs

简介:现有基于三维高斯泼溅的场景理解方法依赖逐视角的二维语义优化过程,训练过程缓慢且难以保持跨视角的语义一致性。本文提出一种无需训练的开放词汇三维场景理解框架:首先在三维高斯场景中进行基于对比式分割,提取空间紧凑、语义一致的超点;随后引入多粒度SAM掩码引导超点逐层合并,构建具备部件到物体层级结构的超点图;再通过高效的反投影策略,将二维语义特征直接映射到各级超点,构建出结构完备、多视角一致的三维语义场。该框架消除了迭代训练开销,同时支持粗粒度目标与细粒度部件的开放词汇查询、交互式分割。实验结果表明,本文的方法在多个开放词汇基准数据集上取得了最先进的分割性能,同时语义场构建速度提升超过30倍,这验证了其在高效三维场景理解中的实用价值。

该论文共同第一作者是厦门大学信息学院2024级硕士研究生代绍辉和2023级博士研究生曲延松,通讯作者是曹刘娟教授,由2022级本科生李哲彦、2023级博士生李新阳、张声传副教授共同合作完成。

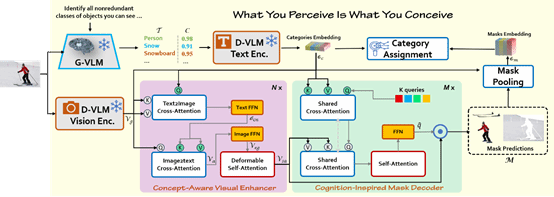

02. What You Perceive Is What You Conceive: A Cognition Inspired Framework for Open Vocabulary Image Segmentation

简介:本文提出了一种灵感源自人类视觉认知模型的新型图像分割方法。不同于传统先做无类别分割再与词汇对齐的流程,该方法首先通过生成型视觉-语言模型(G VLM)读取图像并生成可能出现的语义概念,从而形成“先构念再感知”的思维路径;紧接着,利用一个结合文本概念与视觉特征的模块进一步激发模型对这些语义线索的视觉敏感度;最后,使用一个认知启发式解码器根据预生成的概念线索,仅对相关类别子集执行细粒度分割,实现了更高效、更语义一致的图像理解过程。该框架不仅模拟了人类视觉“理解先于定位”的思路,也在多数据集上展示了对新词汇的良好泛化能力。这一建立在人类认知路径上的框架不仅改变了传统“先分割再匹配”的流程,还显著增强了开放词汇分割对新语义类别的泛化能力,为未来在动态词汇环境中的视觉理解任务提供了新的思路和方向。

该论文第一作者为厦门大学信息学院2023级博士生林将航,通讯作者是曹刘娟教授,由2024级硕士生胡越、沈江涛,腾讯优图实验室沈云航,张声传副教授,纪荣嵘教授等共同合作完成。

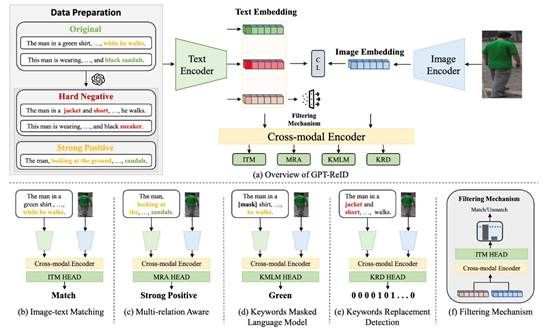

03. GPT-ReID: Learning Fine-grained Representation with GPT for Text-based Person Retrieval

简介:本文提出了一种名为 GPT-ReID 的新颖框架,用于文本描述驱动的行人检索任务(Text-Based Person Retrieval, TBPR)。该方法充分利用大语言模型(LLMs)的强大生成与理解能力,通过引入 GPTGAN 模块生成高质量的增强数据,包括强正样本描述与难负样本描述,缓解了数据不足和过拟合问题。同时,设计了三个辅助任务:多关系感知(MRA)、关键词掩码语言建模(KMLM)与关键词替换检测(KRD),在全局与局部层面提升图文细粒度对齐能力。实验结果表明,GPT-ReID 在多个基准数据集上显著优于现有方法,验证了其在跨模态语义对齐与检索准确性方面的有效性。

该论文第一作者是厦门大学人工智能研究院2022级硕士生王旭东,通讯作者是戴平阳高级工程师,由谭磊(新加坡国立大学)、曹刘娟教授、纪荣嵘教授共同合作完成。

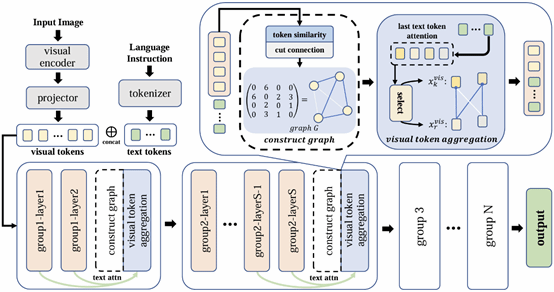

04. VISA: Group-wise Visual Token Selection and Aggregation via Graph Summarization for Efficient MLLMs Inference

简介:本文提出了一种名为“分组视觉标记选择与聚合”(VISA)的新方法,用以解决多模大型语言模型(MLLM)中视觉标记过多导致推理效率低下的问题。与以往的标记剪枝方法相比,本文方法在压缩视觉标记的同时保留了最多的视觉信息。首先提出了一个基于图的视觉标记聚合(VTA)模块。VTA将每个视觉标记视为一个节点,并根据视觉标记之间的语义相似性形成一个图。然后,基于该图将已移除标记的信息聚合到已保留的标记中,从而生成更紧凑的视觉标记表示。此外,本文还引入了一种分组标记选择策略(GTS),将视觉标记划分为已保留标记和已移除标记,并以来自每个组最后层的文本标记为指导。该策略逐步聚合视觉信息,增强了视觉信息提取过程的稳定性。在LLaVA-1.5、LLaVA-NeXT和Video-LLaVA上进行了多个基准测试的全面实验验证了本文方法的有效性且始终优于以前的方法,VISA在模型性能和推理速度之间实现了卓越的平衡。

该论文第一作者是厦门大学信息学院2023级硕士生蒋鹏飞,通讯作者是晁飞副教授,由李汉俊(腾讯优图)、赵凌览(腾讯优图)、鄢科(腾讯优图)、丁守鸿(腾讯优图)、纪荣嵘教授等共同合作完成。

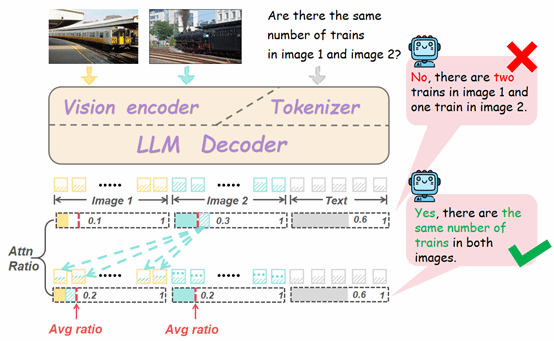

05. MIHBench: Benchmarking and Mitigating Multi-Image Hallucinations in Multimodal Large Language Models

简介:近年来,多模态大语言模型(MLLMs)在生成任务中的“幻觉”问题引发了广泛关注。然而,现有研究几乎全部聚焦于单图像场景,对多图像设置下的幻觉现象仍属空白。针对这一研究缺口,本文首次系统性地探讨了多图像条件下的多模态幻觉问题,并提出全新基准 MIHBench,专为评估多图像场景中与对象相关的幻觉现象而设计。MIHBench涵盖三大核心任务:对象存在幻觉、对象数量幻觉与对象身份一致性幻觉,旨在全面考察模型在跨图像对象识别、数量推理及身份一致性判断等方面的语义理解能力。基于大规模实验分析,本文揭示了多图像幻觉发生的关键影响因素,包括:(1)图像输入数量与幻觉发生可能性之间的递进关系;(2)单图像幻觉倾向与多图像上下文中观察到的倾向之间的强相关性;(3)图像序列中相同对象比例和负样本位置对对象身份一致性幻觉发生的影响。为缓解上述问题,本文提出了一种动态注意力平衡机制(DAB),通过在图像间动态调整注意力分布,有效保持整体视觉关注稳定。实验结果显示,DAB显著提升了多个主流MLLM在多图像场景下的语义整合与推理稳定性,大幅降低幻觉生成频率。

该论文共同第一作者是厦门大学信息学院2022级本科生李嘉乐和2023级博士生吴明瑞,通讯作者是纪家沂博士后研究员,由孙晓帅教授、曹刘娟教授、纪荣嵘教授等共同合作完成。

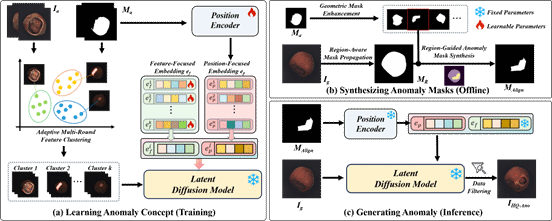

06. Generate Aligned Anomaly: Region-Guided Few-Shot Anomaly Image-Mask Pair Synthesis for Industrial Inspection

简介:工业异常检测受限于样本稀缺,而现有合成方法普遍存在真实感不足、掩模对齐不准及泛化性差等问题。为此,本文提出生成对齐异常(GAA),一种基于区域引导的小样本异常图像-掩模对生成框架。GAA创新性地利用预训练潜在扩散模型的强先验知识,通过三个关键模块实现高质量异常合成:首先,局部概念分解模块联合建模异常语义特征与空间分布,实现对异常类型及位置的细粒度控制;其次,自适应多轮聚类模块对异常概念进行层次化语义聚类,增强表征一致性;最后,区域引导掩模生成与质量过滤模块通过空间约束确保异常-掩模精确对齐,并引入低质量样本过滤机制提升合成数据可靠性。在MVTec AD与LOCO数据集的广泛实验表明,GAA在异常合成质量及下游定位、分类任务中均展现出显著优势。

该论文第一作者是厦门大学信息学院2023级硕士生卢轶霖,通讯作者是张声传副教授,由2023级博士生林将航、2022级硕士生谢林煌、赵凯(VIVO)、2023级博士曲延松、曹刘娟教授、纪荣嵘教授等共同合作完成。

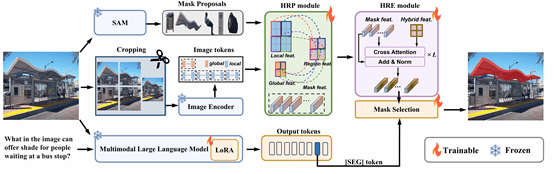

07. HRSeg: High-Resolution Visual Perception and Enhancement for Reasoning Segmentation

简介:推理分割任务旨在根据用户隐含指令对图像中的目标进行分割,这些指令往往包含上下文线索和开放世界知识等隐性语义。尽管现有方法已取得显著进展,但仍受到感知分辨率不足的限制,原因在于视觉编码器通常在较低分辨率下进行预训练。单纯通过插值方式提升视觉编码器的位置嵌入,虽可略微改善性能,但代价是计算资源的大幅增加,收益有限。为解决这一问题,本文提出了一种高效的高分辨率细粒度感知模型。该模型包含两项关键创新:高分辨率感知模块和高分辨率增强模块。前者通过裁剪策略处理高分辨率图像,并融合局部与全局特征,实现多粒度的图像理解;后者则在掩码特征中引入高分辨率图像的细节信息,从而提升与文本特征的对齐精度,实现更为精确的目标分割。在多个基准数据集上的综合评估显示出HRSeg在性能上的全面优越性。

该论文共同第一作者是厦门大学信息学院2024级硕士生林玮煌和2023级博士生马祎炜,通讯作者是孙晓帅教授,由博士后研究员纪家沂、何淑婷(上海财经大学)、曹刘娟教授、纪荣嵘教授共同合作完成。

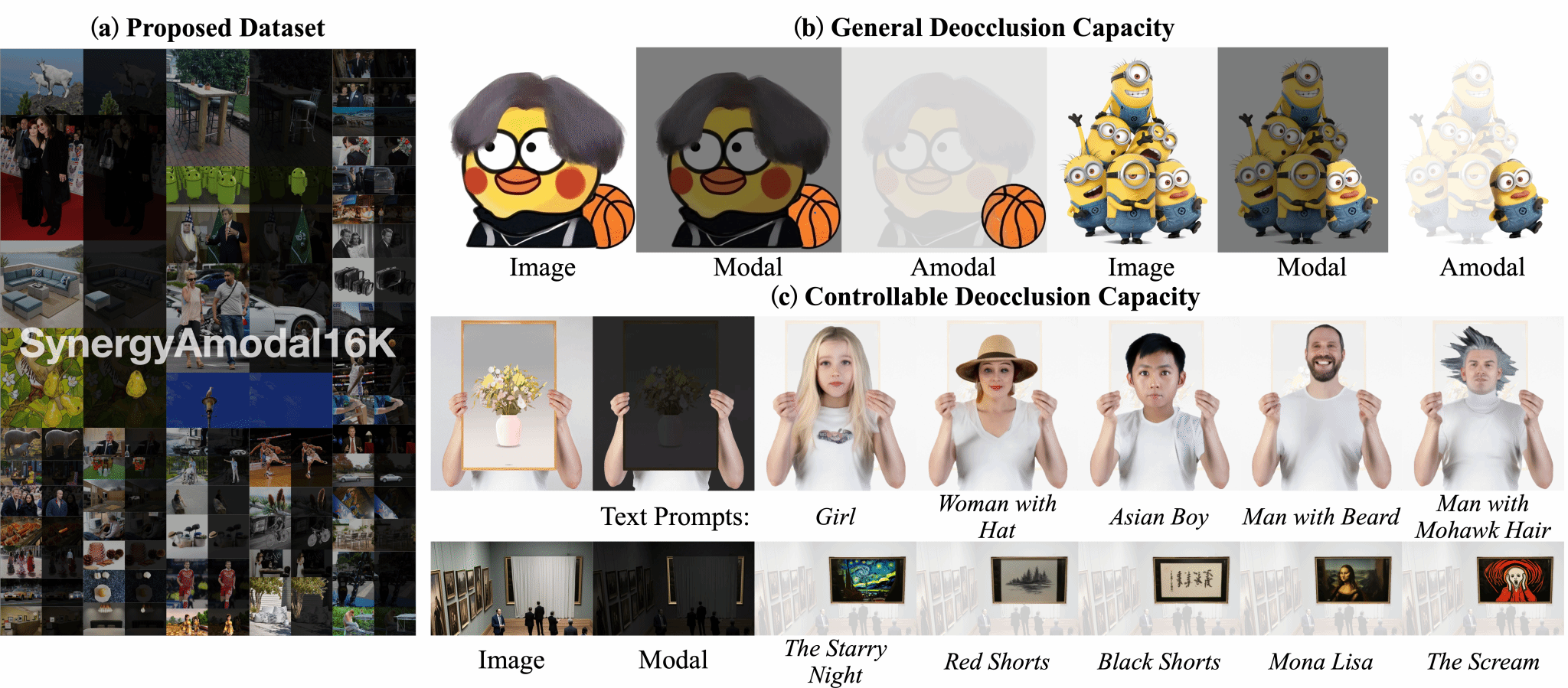

08. SynergyAmodal: Deocclude Anything with Text Control

简介:针对模态补全任务在高质量数据上的匮乏问题,本文确定了三个关键要素:利用野外图像数据实现多样性,结合人类专业知识实现合理性,以及利用生成先验实现真实性。本文提出了SynergyAmodal,这是一个新颖的框架,用于共同合成具有全面形状和外观注释的野外非模态数据集。该框架通过数据-专家-模型三方协作整合了这些要素。具体来说,首先,本文设计了一个基于遮挡的自监督学习算法,以利用野外图像数据的多样性,将修复扩散模型微调为部分补全扩散模型。其次,本文建立了一个共同合成流程,迭代地过滤、优化、选择和注释部分补全扩散模型的初始去遮挡结果,通过人类专家指导和先验模型约束确保合理性和真实性。该流程生成了一个高质量的成对非模态数据集,涵盖了广泛的类别和尺度多样性,包括大约16K对样本。最后,本文在合成的数据集上训练了一个完整的补全扩散模型,并将文本提示作为条件信号纳入其中。大量实验表明,该框架在实现零样本泛化和文本可控性方面具有显著效果。

该论文第一作者是厦门大学信息学院2023级博士生李新阳,通讯作者是张声传副教授,由2024级硕士生伊承杰、2023级硕士生赖嘉炜、林明宝(乐天亚洲私人有限公司)、2023级博士生曲延松和曹刘娟教授合作完成。