MAC实验室七篇论文被NeurIPS 2024接收,涵盖多模态大模型、三维视觉、行人重识别等多个研究方向。

Thirty-Eighth Annual Conference on Neural Information Processing Systems(NeurIPS 2024)将于2024年12月9日至15日在加拿大温哥华举行。NeurIPS是人工智能与机器学习领域的三大国际会议(NeurIPS、ICML、ICLR)之一,CCF A类会议。今年NeurIPS投稿量再创新高,共有15671篇有效投稿,接收率25.8%。代码数据陆续开源中。

被录用论文的简要介绍如下:

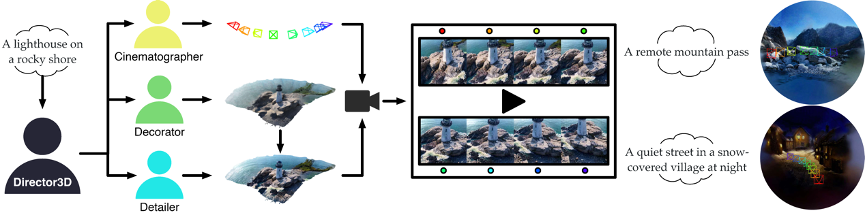

1. Director3D: Real-world Camera Trajectory and 3D Scene Generation from Text

本文提出了一个鲁棒的开放世界文本到3D生成框架Director3D,旨在生成真实世界的3D场景和自适应的相机轨迹。Director3D可以像导演一样指导3D场景的生成:(1)使用一个轨迹扩散变换器作为摄影师,根据文本描述来建模相机轨迹的分布;(2)一个由高斯驱动的多视图潜变量扩散模型作为场景布置师,根据相机轨迹和文本来建模图像序列分布。这个模型是从一个2D扩散模型微调而来,可以直接生成与像素对齐的3D高斯,作为直接的3D场景表现形式,用于三维一致的去噪;(3)这些3D高斯通过一种新颖的融合了2D扩散模型先验知识的SDS++损失,作为场景细化师进一步细化得到真实的3D场景。大量的实验表明Director3D在真实世界的3D场景生成中超越之前的最先进方案,达到了SOTA的效果。相关代码已经开源。

该论文第一作者是信息学院2023级博士生李新阳,通讯作者是曹刘娟教授,由2023级硕士生赖章宇、徐霖宁博士(香港中文大学)、2023级博士生曲延松、张声传助理教授、戴勃研究科学家(上海人工智能实验室和纪荣嵘教授共同合作完成。

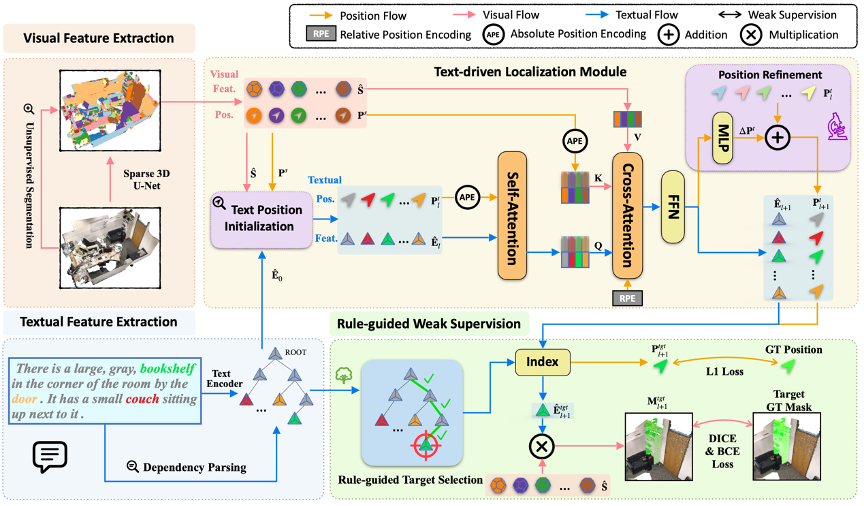

2. RG-SAN: Rule-Guided Spatial Awareness Network for End-to-End 3D Referring Expression Segmentation

3D指向性分割(3D-RES)旨在根据自然语言描述在三维空间中分割特定实例。然而,由于对实例空间信息的建模不足,传统方法经常会遇到过分割或错误分割等问题。本文基于仅利用目标空间信息的弱监督策略,提出了规则引导的空间感知网络(RG-SAN)。这种方法使模型能够准确地学习文本中所有实体之间的空间关系,从而增强空间推理能力。RG-SAN由文本驱动的本地化模块(TLM)和规则引导的弱监督(RWS)策略组成。TLM最初定位所有文本提及的实例,并迭代细化其位置信息。RWS策略凭借仅有的目标位置监督信息,使用依存树规则来精确指导核心实例的定位。对ScanRefer基准的广泛测试表明,RG-SAN不仅建立了新的性能基准,而且在处理空间模糊性描述时,鲁棒性明显提升。

该论文的共同第一作者是人工智能研究院2024级博士吴昌鲡与信息学院人工智能系2023级硕士陈琦,通讯作者是纪荣嵘教授,由博士后研究员纪家沂、孙晓帅教授等共同合作完成。

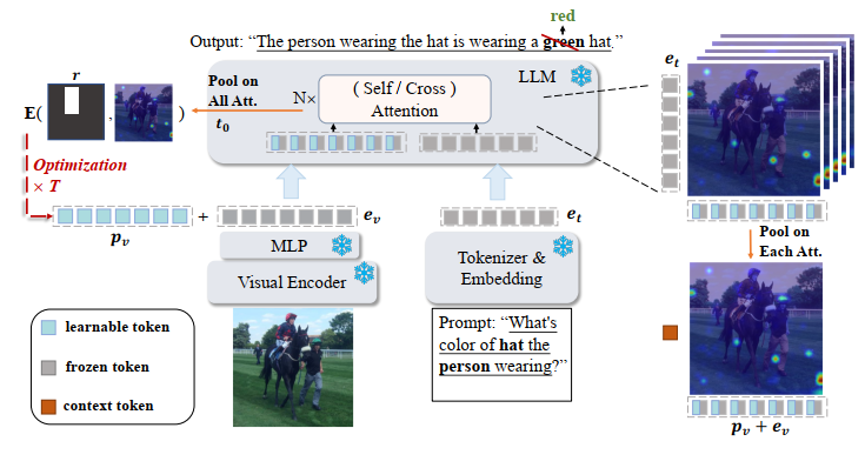

3. ControlMLLM: Training-Free Visual Prompt Learning for Multimodal Large Language Models

本文提出了一种无训练的方法,通过可学习的潜变量优化,将视觉提示注入多模态大型语言模型(MLLMs)。本文观察到,注意力机制作为MLLMs的核心模块,连接了文本提示标记和视觉标记,从而最终决定生成结果。本文的研究方法在推理过程中调整来自多层感知机(MLP)输出的视觉标记,控制注意力响应,以确保文本提示标记能够关注到指代区域中的视觉标记。本文基于能量函数优化一个可学习的潜变量,增强注意力图中引用区域的强度。这一方法使得在无需大量训练成本或模型重训练的情况下,能够实现详细的区域描述和推理。本文的研究方法为将引用能力整合进多模态大型语言模型提供了一个有前景的方向,并支持使用框、掩膜、涂鸦和点进行指代。结果表明,本文的方法展示了域外数据上的泛化能力和可解释性。

该论文第一作者是人工智能研究院2023级博士生吴明瑞,通讯作者是纪家沂博士后研究员,由孙晓帅教授、纪荣嵘教授等共同合作完成。

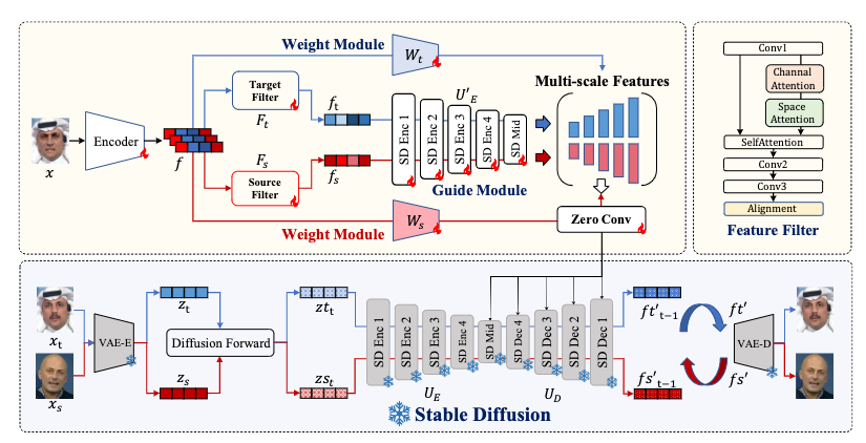

4. DiffusionFake: Enhancing Generalization in Deepfake Detection via Guided Stable Diffusion

本文针对人工智能生成内容(AIGC)技术的快速发展,特别是Deepfake等换脸技术的广泛应用所带来的安全挑战,提出了一种新颖的人脸篡改检测方法。本文通过分析Deepfake图像的生成过程,发现了一个关键洞见:Deepfake图像本质上融合了源图像和目标图像的信息,而真实图像则保持一致的身份特征。基于这一洞见,论文提出了DiffusionFake框架,这是一种即插即用的方法,即通过利用预训练的Stable Diffusion模型来指导检测器学习Deepfake中固有的源和目标特征。DiffusionFake通过反转生成过程来增强现有检测器的泛化能力,无需额外的推理参数即可显著提高检测模型在未见数据集上的性能。实验结果表明,该方法在各种检测器架构上都取得了显著的跨域泛化性能提升,为应对日益复杂的人脸篡改技术提供了一种有效的解决方案。

本文第一作者是信息学院2021级博士生孙可,通讯作者是刘宏(大阪大学),由陈燊(腾讯优图)、姚太平(腾讯优图)、丁守鸿(腾讯优图)、孙晓帅教授,纪荣嵘教授等共同合作完成。

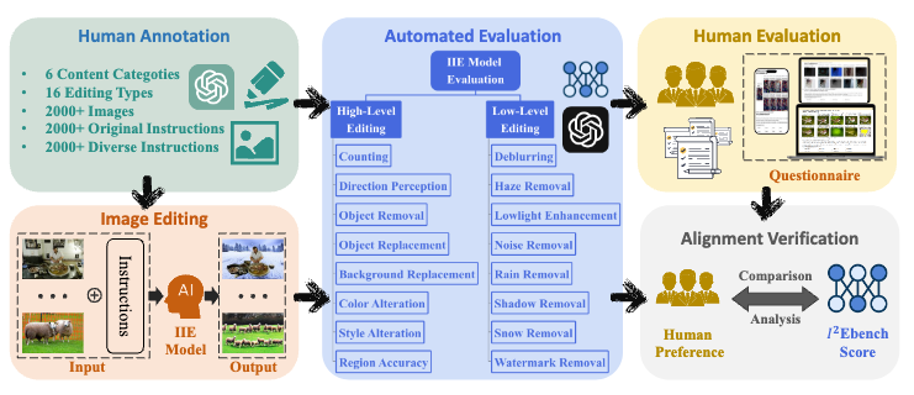

5. I2EBench: A Comprehensive Benchmark for Instruction-based Image Editing

本文提出了一个名为I2EBench的综合基准,用于自动评估基于指令的图像编辑(IIE)模型生成的编辑图像的质量。针对目前IIE模型评估中的显著挑战,I2EBench从多个维度进行全面评估,旨在为其进一步发展提供有价值的见解。具体而言,I2EBench包含了2000多张待编辑图像,以及4000多条对应的原始和多样化指令。本文的创新点如下:第一,全面的评估维度:I2EBench包括16个评估维度,覆盖了高层次和低层次的各个方面,提供了对每个IIE模型的全面评估。第二,与人类感知对齐:为了确保基准与人类感知的一致性,本文针对每个评估维度进行了广泛的用户研究。第三,有价值的研究见解:通过分析现有IIE模型在16个维度上的优劣,本文提出了指导未来研究发展的重要见解。

本文共同第一作者是信息学院2023级博士生马祎炜和博士后研究员纪家沂,通讯作者是孙晓帅教授,由信息学院2024级硕士生叶柯、林玮煌、2022级本科生郑永涵、纪荣嵘教授共同合作完成。

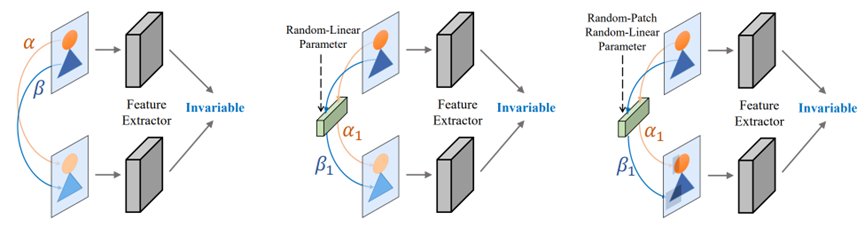

6. RLE: A Unified Perspective of Data Augmentation for Cross-Spectral Re-Identification

本文旨在对跨光谱重新识别任务中的模态差异进行建模。基于朗伯体模型,本文解释了非线性跨光谱模态差异主要来自于作用于不同材料表面的差异化线性变换因子。从这个角度来看,本文为所有面向跨光谱重识别的数据增强策略提供了一个统一的视角:即通过模仿这种局部线性变换,来促进网络对这种变换鲁棒。根据变换的强弱,本文将其分为温和变换和激进变换,并针对性两种变换分别提出了温和随机线性增强(MRLE)和激进随机线性增强(RRLE),以突破这两种变换类型的边界。温和随机线性增强旨在提供满足原始局部线性相关性的温和局部线性变换,而激进随机线性增强则寻求直接进行局部线性变换而不依赖外部信息。实验结果不仅证明了所提出的随机线性变换策略的优越性和有效性,而且证实了其作为跨光谱重新识别的通用数据增强的巨大潜力。

该论文的第一作者是厦门大学信息学院人工智能系2020级博士生谭磊,通讯作者是戴平阳高级工程师,由张岩工程师、吴永坚(腾讯优图)、纪荣嵘教授等共同合作完成。

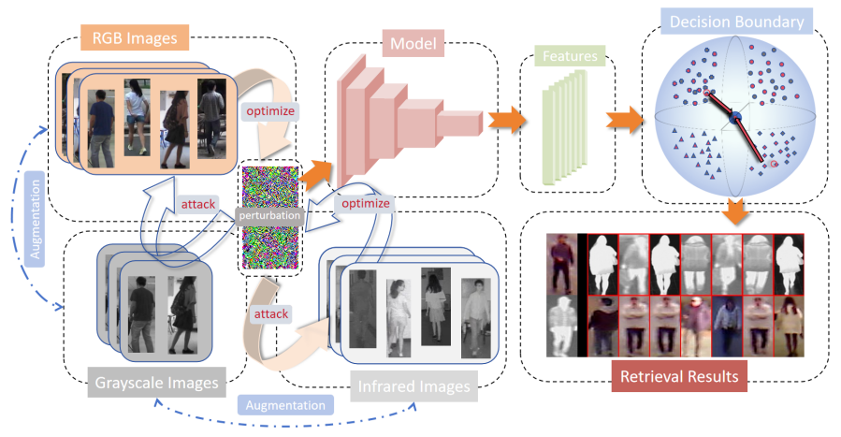

7. Cross-Modality Perturbation Synergy Attack for Person Re-identification

近年来,针对基于RGB图像的单模态行人重识别(ReID)系统的安全性问题,已有大量研究工作。然而,在实际应用中更为常见的涉及红外摄像头拍摄图像的跨模态场景的安全性却未得到充分关注。跨模态ReID的主要挑战在于有效处理不同模态之间的视觉差异。例如,红外图像通常为灰度图,而可见光图像则包含颜色信息。现有的攻击方法主要集中于可见光图像模态的特性,忽视了其他模态的特征以及不同模态之间的数据分布差异。这种忽视可能会削弱这些方法在多模态图像检索中的有效性。本研究首次探讨了跨模态RID模型的安全性,并提出了一种专为跨模态ReID设计的通用扰动攻击。该攻击通过利用来自多模态数据的梯度优化扰动,从而破坏判别器并强化模态之间的差异。我们在两个广泛使用的跨模态数据集RegDB和SYSU上进行了实验,实验结果不仅证明了我们方法的有效性,还为未来增强跨模态ReID系统的鲁棒性提供了新的见解。

该论文的第一作者为2023级博士研究生龚云鹏,通讯作者为江敏教授。该研究成果是与钟准助理教授(诺丁汉大学)、罗志明副教授、2023纪博士研究生曲延松、纪荣嵘教授共同合作完成。