近日,国际顶级学术期刊 《IEEE Transactions on Pattern Analysis and Machine Intelligence》(TPAMI)接收了厦门大学信息学院纪荣嵘教授团队的最新研究成果“Training-free Transformer Architecture Search with Zero-cost Proxy Guided Evolution”。TPAMI是计算机学科领域最顶级的国际期刊,其影响因子24.314。

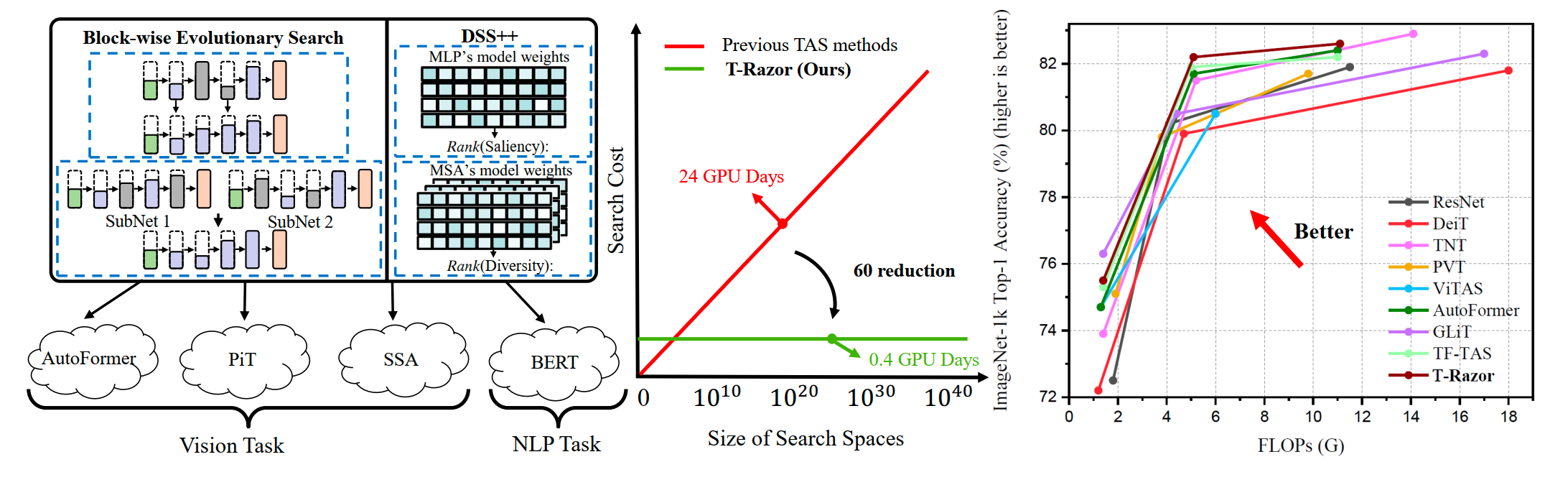

该论文提出了一种高效的Transformer结构搜索方法(T-Razor),采用零代价代理引导的进化算法来加速Transformer结构搜索的效率。T-Razor基于Transformer结构的多头注意力模块(MSA)和多层感知机模块(MLP)的多样性和显著性排序情况构建了面向Transformer结构的零代价代理指标,称为DSS++。通过利用MSA模块的多样性排序和MLP模块的显著性排序,T-Razor有效地估计了给定搜索空间中不同Transformer结构之间的相对性能排序。该论文中还提出了一种与DSS++结合的模块级进化搜索方法,进一步提高搜索效率并改善搜索结果。与其他主流的Transformer结构搜索方法相比,由DSS++指导的模块级进化搜索在涉及视觉任务和自然语言处理(NLP)任务的复杂Transformer搜索空间中实现了有竞争力的性能。此外,T-Razor显著提高了Transformer结构搜索的效率,仅需约0.4 个GPU天数即可实现对相对最优的Transformer结构的搜索。

具体来说,该论文首先分析了Transformer结构的MSA和MLP模块的不同属性之间对评估Transformer结构的影响,MSA模块的多样性和MLP模块的显著性度量之间存在量级差异,导致直接结合二者对Transformer结构的评估出现不稳定现象。基于这一研究发现,该论文提出在结合MSA模块的多样性和MLP模块的显著性度量之前,引入当前搜索到的所有Transformer结构在这两个度量上的相对关系,成功将原先搜索过程中的Transformer结构的相互独立状态转换为相互联系的状态,从而实现更准确的Transformer结构评估。为进一步加速在复杂的Transformer搜索空间上的搜索效率,论文构建了创新的模块级进化搜索算法,利用DSS++天然的模块化性质,引导Transformer结构在搜索过程中进行交叉和变异。论文通过实验展示了所提出的T-Razor算法的高效性,在多个复杂Transformer搜索空间上仅需约0.4 GPU个天数即可实现对优秀Transformer子结构的搜索,在ImageNet上相对目前的SOTA方法最高可以提升1.7个百分点。为进一步评估T-Razor,论文扩展了搜索空间以覆盖视觉和NLP任务。对于视觉任务,论文验证了T-Razor在Shunted-ViT搜索空间上的有效性。对于NLP任务,论文在BERT搜索空间上进行了实验,结果表明T-Razor在GLUE的多个NLP数据集上取得了有竞争力的性能,达到81.2的均分。

该论文由厦门大学信息学院媒体分析与计算实验室(MAC)博士生周勤勤与其导师纪荣嵘教授、郑侠武副教授,北京大学陈杰教授和田永鸿教授等合作完成。纪荣嵘教授团队系列研究成果的发布标志着我校在信息学科人工智能研究领域影响力的逐步提升。本项研究得到了包括国家杰出青年科学基金在内的项目的支持。